Frequently Asked Questions

For Management

- Why should I use Slurm or other Free Open Source Software (FOSS)?

Slurmまたは他の無料のオープンソースソフトウェア(FOSS)を使用する必要があるのはなぜですか?

For Users

- Why is my job/node in a COMPLETING state?

ジョブ/ノードがCOMPLETING状態になるのはなぜですか? - Why are my resource limits not propagated?

リソース制限が反映されないのはなぜですか? - Why is my job not running?

なぜ私の仕事が実行されないのですか? - Why does the srun --overcommit option not permit

multiple jobs to run on nodes?

srun --overcommitオプションが複数のジョブのノードでの実行を許可しないのはなぜですか? - Why is my job killed prematurely?

なぜ私の仕事は時期尚早に殺されるのですか? - Why are my srun options ignored?

srunオプションが無視されるのはなぜですか? - Why is the Slurm backfill scheduler not starting my

job?

Slurmバックフィルスケジューラがジョブを開始しないのはなぜですか? - How can I run multiple jobs from within a single

script?

単一のスクリプト内から複数のジョブを実行するにはどうすればよいですか? - How can I run a job within an existing job

allocation?

既存のジョブ割り当て内でジョブを実行するにはどうすればよいですか? - How does Slurm establish the environment for my

job?

Slurmは私の仕事のための環境をどのように確立しますか? - How can I get shell prompts in interactive mode?

対話モードでシェルプロンプトを取得するにはどうすればよいですか? - How can I get the task ID in the output or error file

name for a batch job?

バッチジョブの出力またはエラーファイル名でタスクIDを取得するにはどうすればよいですか? - Can the make command utilize the resources

allocated to a Slurm job?

makeコマンドはSlurmジョブに割り当てられたリソースを利用できますか? - Can tasks be launched with a remote (pseudo)

terminal?

リモート(疑似)端末でタスクを起動できますか? - What does "srun: Force Terminated job"

indicate?

「srun:Force Terminated job」は何を示していますか? - What does this mean: "srun: First task exited

30s ago" followed by "srun Job Failed"?

これはどういう意味ですか:「srun:最初のタスクは30秒前に終了しました」に続いて「srun Job Failed」 - Why is my MPI job failing due to the locked memory

(memlock) limit being too low?

ロックされたメモリ(memlock)の制限が低すぎるためにMPIジョブが失敗するのはなぜですか? - Why is my batch job that launches no job steps being

killed?

ジョブステップを起動しないバッチジョブが強制終了されるのはなぜですか? - How do I run specific tasks on certain nodes

in my allocation?

割り当ての特定のノードで特定のタスクを実行するにはどうすればよいですか? - How can I temporarily prevent a job from running

(e.g. place it into a hold state)?

ジョブの実行を一時的に防ぐにはどうすればよいですか(たとえば、ジョブをホールド状態にするなど)? - Why are jobs not getting the appropriate

memory limit?

ジョブが適切なメモリ制限を取得しないのはなぜですか? - Is an archive available of messages posted to

the slurm-users mailing list?

slurm-usersメーリングリストに投稿されたメッセージのアーカイブはありますか? - Can I change my job's size after it has started

running?

実行開始後にジョブのサイズを変更できますか? - Why is my MPICH2 or MVAPICH2 job not running with

Slurm? Why does the DAKOTA program not run with Slurm?

MPICH2またはMVAPICH2ジョブがSlurmで実行されないのはなぜですか?DAKOTAプログラムがSlurmで実行されないのはなぜですか? - Why does squeue (and "scontrol show

jobid") sometimes not display a job's estimated start time?

squeue(および「scontrol show jobid」)がジョブの推定開始時刻を表示しないことがあるのはなぜですか? - How can I run an Ansys program with Slurm?

SlurmでAnsysプログラムを実行するにはどうすればよいですか? - How can a job in a complete or failed state be requeued?

完了または失敗した状態のジョブをどのように再キューイングできますか? - Slurm documentation refers to CPUs, cores and threads.

What exactly is considered a CPU?

Slurmのドキュメントでは、CPU、コア、スレッドについて言及しています。正確には何がCPUと見なされますか? - What is the difference between the sbatch

and srun commands?

sbatchコマンドとsrunコマンドの違いは何ですか? - Can squeue output be color coded?

squeueの出力を色分けできますか? - Can Slurm export an X11 display on an allocated compute node?

Slurmは割り当てられた計算ノードでX11ディスプレイをエクスポートできますか? - Why is the srun --u/--unbuffered option adding

a carriage return to my output?

srun --u /-unbufferedオプションが出力に改行を追加するのはなぜですか? - Why is sview not coloring/highlighting nodes

properly?

sviewがノードを適切に色付け/強調表示しないのはなぜですか?

For Administrators

- How is job suspend/resume useful?

ジョブの一時停止/再開はどのように役立ちますか? - Why is a node shown in state DOWN when the node

has registered for service?

ノードがサービスに登録されているのに、ノードがDOWN状態で表示されるのはなぜですか? - What happens when a node crashes?

ノードがクラッシュするとどうなりますか? - How can I control the execution of multiple

jobs per node?

ノードごとに複数のジョブの実行を制御するにはどうすればよいですか? - When the Slurm daemon starts, it prints

"cannot resolve X plugin operations" and exits. What does this mean?

Slurmデーモンが起動すると、「Xプラグイン操作を解決できません」と出力して終了します。これは何を意味するのでしょうか? - How can I exclude some users from pam_slurm?

一部のユーザーをpam_slurmから除外するにはどうすればよいですか? - How can I dry up the workload for a maintenance

period?

メンテナンス期間のワークロードをどのように枯渇させることができますか? - How can PAM be used to control a user's limits on or

access to compute nodes?

PAMを使用して、計算ノードに対するユーザーの制限またはアクセスを制御するにはどうすればよいですか? - Why are jobs allocated nodes and then unable to initiate

programs on some nodes?

ジョブがノードに割り当てられ、一部のノードでプログラムを開始できないのはなぜですか? - Why does slurmctld log that some nodes

are not responding even if they are not in any partition?

一部のノードがどのパーティションにもない場合でも、slurmctldが応答していないことをログに記録するのはなぜですか? - How should I relocate the primary or backup

controller?

プライマリコントローラまたはバックアップコントローラを再配置するにはどうすればよいですか? - Can multiple Slurm systems be run in

parallel for testing purposes?

テスト目的で複数のSlurmシステムを並行して実行できますか? - Can Slurm emulate a larger cluster?

Slurmはより大きなクラスターをエミュレートできますか? - Can Slurm emulate nodes with more

resources than physically exist on the node?

Slurmは、ノードに物理的に存在するよりも多くのリソースを持つノードをエミュレートできますか? - What does a

"credential replayed" error in the SlurmdLogFile

indicate?

SlurmdLogFileの「資格情報の再生」エラーは何を示していますか? - What does

"Warning: Note very large processing time"

in the SlurmctldLogFile indicate?

SlurmctldLogFileの「警告:処理時間が非常に長いことに注意してください」とはどういう意味ですか? - Is resource limit propagation

useful on a homogeneous cluster?

同種のクラスターでリソース制限の伝播は役に立ちますか? - Do I need to maintain synchronized clocks

on the cluster?

クラスターで同期クロックを維持する必要がありますか? - Why are "Invalid job credential" errors

generated?

「無効なジョブ資格情報」エラーが生成されるのはなぜですか? - Why are

"Task launch failed on node ... Job credential replayed"

errors generated?

「ノードでタスクの起動に失敗しました...ジョブ資格情報が再生されました」というエラーが生成されるのはなぜですか? - Can Slurm be used with Globus?

SlurmをGlobusで使用できますか? - What causes the error

"Unable to accept new connection: Too many open files"?

「新しい接続を受け入れることができません:開いているファイルが多すぎます」というエラーの原因は何ですか? - Why does the setting of SlurmdDebug fail

to log job step information at the appropriate level?

SlurmdDebugの設定がジョブステップ情報を適切なレベルでログに記録できないのはなぜですか? - Why aren't pam_slurm.so, auth_none.so, or other components in a

Slurm RPM?

Slurm RPMにpam_slurm.so、auth_none.so、またはその他のコンポーネントがないのはなぜですか? - Why should I use the slurmdbd instead of the

regular database plugins?

通常のデータベースプラグインの代わりにslurmdbdを使用する必要があるのはなぜですか? - How can I build Slurm with debugging symbols?

デバッグシンボルを使用してSlurmをビルドするにはどうすればよいですか? - How can I easily preserve drained node

information between major Slurm updates?

Slurmの主要な更新間でドレインされたノード情報を簡単に保持するにはどうすればよいですか? - Why doesn't the HealthCheckProgram

execute on DOWN nodes?

HealthCheckProgramがDOWNノードで実行されないのはなぜですか? - What is the meaning of the error

"Batch JobId=# missing from batch node <node> (not found

BatchStartTime after startup)"?

「バッチノードにバッチジョブID =#がありません」というエラーの意味は何ですか (起動後にBatchStartTimeが見つかりません) "? - What does the message

"srun: error: Unable to accept connection: Resources temporarily unavailable"

indicate?

「srun:エラー:接続を受け入れることができません:リソースが一時的に利用できません」というメッセージは何を示していますか? - How could I automatically print a job's

Slurm job ID to its standard output?

ジョブのSlurmジョブIDを標準出力に自動的に印刷するにはどうすればよいですか? - Why are user processes and srun

running even though the job is supposed to be completed?

ジョブが完了しているはずなのに、ユーザープロセスとsrunが実行されているのはなぜですか? - How can I prevent the slurmd and

slurmstepd daemons from being killed when a node's memory

is exhausted?

ノードのメモリが使い果たされたときにslurmdとslurmstepdデーモンが強制終了されるのを防ぐにはどうすればよいですか? - I see the host of my calling node as 127.0.1.1

instead of the correct IP address. Why is that?

呼び出し元ノードのホストが正しいIPアドレスではなく127.0.1.1として表示されます。何故ですか? - How can I stop Slurm from scheduling jobs?

Slurmでジョブのスケジュールを停止するにはどうすればよいですか? - Can I update multiple jobs with a single

scontrol command?

1つのscontrolコマンドで複数のジョブを更新できますか? - Can Slurm be used to run jobs on Amazon's EC2?

Slurmを使用してAmazonのEC2でジョブを実行できますか? - If a Slurm daemon core dumps, where can I find the

core file?

Slurmデーモンコアダンプの場合、コアファイルはどこにありますか? - How can TotalView be configured to operate with

Slurm?

TotalViewをSlurmで動作するように構成するにはどうすればよいですか? - How can a patch file be generated from a Slurm commit

in GitHub?

GitHubのSlurmコミットからパッチファイルを生成するにはどうすればよいですか? - Why are the resource limits set in the database

not being enforced?

データベースに設定されているリソース制限が適用されないのはなぜですか? - After manually setting a job priority value,

how can its priority value be returned to being managed by the

priority/multifactor plugin?

ジョブの優先度の値を手動で設定した後、優先度の値を優先度/多要素プラグインによる管理に戻すにはどうすればよいですか? - Does anyone have an example node health check

script for Slurm?

誰かがSlurmのノードヘルスチェックスクリプトの例を持っていますか? - What process should I follow to add nodes to Slurm?

ノードをSlurmに追加するには、どのプロセスに従う必要がありますか? - Can Slurm be configured to manage licenses?

ライセンスを管理するようにSlurmを構成できますか? - Can the salloc command be configured to

launch a shell on a node in the job's allocation?

ジョブの割り当てのノードでシェルを起動するようにsallocコマンドを構成できますか? - What should I be aware of when upgrading Slurm?

Slurmをアップグレードするときに注意すべきことは何ですか? - How easy is it to switch from PBS or Torque to Slurm?

PBSまたはTorqueからSlurmに切り替えるのはどれほど簡単ですか? - How can I get SSSD to work with Slurm?

SSSDをSlurmと連携させるにはどうすればよいですか? - How critical is configuring high availability for my

database?

データベースの高可用性の構成はどの程度重要ですか? - How can I use double quotes in MySQL queries?

MySQLクエリで二重引用符を使用するにはどうすればよいですか? - Why is a compute node down with the reason set to

"Node unexpectedly rebooted"?

理由が「ノードが予期せず再起動しました」に設定されているコンピューティングノードがダウンしているのはなぜですか? - How can a job which has exited with a specific exit code

be requeued?

特定の終了コードで終了したジョブを再キューイングするにはどうすればよいですか? - Can a user's account be changed in the database?

データベースでユーザーのアカウントを変更できますか? - What might account for MPI performance being below the

expected level?

MPIのパフォーマンスが期待されるレベルを下回っている理由は何ですか? - How could some jobs submitted immediately before the

slurmctld daemon crashed be lost?

slurmctldデーモンがクラッシュする直前に送信された一部のジョブがどのように失われる可能性がありますか? - How do I safely remove partitions?

パーティションを安全に削除するにはどうすればよいですか? - Why is Slurm unable to set the CPU frequency for jobs?

SlurmがジョブのCPU周波数を設定できないのはなぜですか? - When adding a new cluster, how can the Slurm cluster

configuration be copied from an existing cluster to the new cluster?

新しいクラスターを追加するときに、Slurmクラスター構成を既存のクラスターから新しいクラスターにコピーするにはどうすればよいですか? - How can I update Slurm on a Cray DVS file system without

rebooting the nodes?

ノードを再起動せずにCray DVSファイルシステムでSlurmを更新するにはどうすればよいですか? - How can I rebuild the database hierarchy?

データベース階層を再構築するにはどうすればよいですか? - How can a routing queue be configured?

ルーティングキューはどのように構成できますか? - How can I suspend, resume, hold or release all

of the jobs belonging to a specific user, partition, etc?

特定のユーザー、パーティションなどに属するすべてのジョブを一時停止、再開、保留、または解放するにはどうすればよいですか? - I had to change a user's UID and now they cannot submit

jobs. How do I get the new UID to take effect?

ユーザーのUIDを変更する必要があり、ジョブを送信できなくなりました。新しいUIDを有効にするにはどうすればよいですか? - Slurmdbd is failing to start with a 'Duplicate entry'

error in the database. How do I fix that?

Slurmdbdは、データベースの「重複エントリ」エラーで開始に失敗します。どうすれば修正できますか? - Why are applications on my Cray system failing

with SIGBUS (bus error)?

Crayシステム上のアプリケーションがSIGBUS(バスエラー)で失敗するのはなぜですか?

For Management

Why should I use Slurm or other Free Open Source Software (FOSS)?

Slurmまたは他の無料のオープンソースソフトウェア(FOSS)を使用する必要があるのはなぜですか?

Free Open Source Software (FOSS) does not mean that it is without cost.

無料のオープンソースソフトウェア(FOSS)が無料であるという意味ではありません。

It does mean that the you have access to the code so that you are free to

use it, study it, and/or enhance it.

それは、あなたが自由にそれを使用し、それを研究し、そして/またはそれを強化するためにあなたがそのコードにアクセスできることを意味します。

These reasons contribute to Slurm (and FOSS in general) being subject to

active research and development worldwide, displacing proprietary software

in many environments.

これらの理由により、Slurm(およびFOSS全般)は世界中で活発な研究開発の対象となり、多くの環境で独自仕様のソフトウェアに取って代わっています。

If the software is large and complex, like Slurm or the Linux kernel,

then while there is no license fee, its use is not without cost.

SlurmやLinuxカーネルのようにソフトウェアが大きく複雑な場合、ライセンス料はかかりませんが、その使用には費用がかかります。

If your work is important, you'll want the leading Slurm experts at your

disposal to keep your systems operating at peak efficiency.

あなたの仕事が重要な場合は、システムを最高の効率で運用し続けるために、自由に使える主要なSlurmエキスパートが必要です。

While Slurm has a global development community incorporating leading edge

technology, SchedMD personnel have developed

most of the code and can provide competitively priced commercial support.

Slurmには最先端のテクノロジーを組み込んだグローバルな開発コミュニティがありますが、SchedMDの担当者はほとんどのコードを開発しており、低価格の商用サポートを提供できます。

SchedMD works with various organizations to provide a range of support

options ranging from remote level-3 support to 24x7 on-site personnel.

SchedMDはさまざまな組織と連携して、リモートレベル3サポートから24時間365日のオンサイト担当者まで、幅広いサポートオプションを提供しています。

Customers switching from commercial workload mangers to Slurm typically

report higher scalability, better performance and lower costs.

商用のワークロードマネージャーからSlurmに切り替える顧客は、通常、より高いスケーラビリティ、より良いパフォーマンス、より低いコストを報告します。

For Users

Why is my job/node in a COMPLETING state?

ジョブ/ノードがCOMPLETING状態になるのはなぜですか?

When a job is terminating, both the job and its nodes enter the COMPLETING state.

ジョブが終了すると、ジョブとそのノードの両方がCOMPLETING状態になります。

As the Slurm daemon on each node determines that all processes associated with

the job have terminated, that node changes state to IDLE or some other appropriate

state for use by other jobs.

各ノードのSlurmデーモンが、ジョブに関連付けられているすべてのプロセスが終了したと判断すると、そのノードは状態をIDLEまたは他の適切な状態に変更して、他のジョブで使用できるようにします。

When every node allocated to a job has determined that all processes associated

with it have terminated, the job changes state to COMPLETED or some other

appropriate state (e.g. FAILED).

ジョブに割り当てられたすべてのノードが、それに関連付けられたすべてのプロセスが終了したと判断すると、ジョブは状態をCOMPLETEDまたはその他の適切な状態(たとえば、FAILED)に変更します。

Normally, this happens within a second.

通常、これは1秒以内に発生します。

However, if the job has processes that cannot be terminated with a SIGKILL

signal, the job and one or more nodes can remain in the COMPLETING state

for an extended period of time.

ただし、SIGKILLシグナルで終了できないプロセスがジョブにある場合、ジョブと1つ以上のノードが長時間COMPLETING状態のままになることがあります。

This may be indicative of processes hung waiting for a core file

to complete I/O or operating system failure.

これは、コアファイルがI / Oまたはオペレーティングシステムの障害を完了するのを待っているプロセスがハングしていることを示している可能性があります。

If this state persists, the system administrator should check for processes

associated with the job that cannot be terminated then use the

scontrol command to change the node's

state to DOWN (e.g. "scontrol update NodeName=name State=DOWN Reason=hung_completing"),

reboot the node, then reset the node's state to IDLE

(e.g. "scontrol update NodeName=name State=RESUME").

この状態が続く場合、システム管理者は、終了できないジョブに関連付けられたプロセスを確認してから、scontrolコマンドを使用してノードの状態をDOWNに変更します(「scontrol update NodeName = name State = DOWN Reason = hung_completing」など)、再起動します。ノード、次にノードの状態をIDLEにリセットします(例: "scontrol update NodeName = name State = RESUME")。

Note that setting the node DOWN will terminate all running or suspended

jobs associated with that node.

ノードをDOWNに設定すると、そのノードに関連付けられている実行中または一時停止中のすべてのジョブが終了します。

An alternative is to set the node's state to DRAIN until all jobs

associated with it terminate before setting it DOWN and re-booting.

別の方法としては、ノードの状態をDRAINに設定し、それに関連するすべてのジョブを終了してから、DOWNに設定して再起動する方法があります。

Note that Slurm has two configuration parameters that may be used to

automate some of this process.

Slurmには、このプロセスの一部を自動化するために使用できる2つの構成パラメーターがあることに注意してください。

UnkillableStepProgram specifies a program to execute when

non-killable processes are identified.

UnkillableStepProgramは、強制終了できないプロセスが識別されたときに実行するプログラムを指定します。

UnkillableStepTimeout specifies how long to wait for processes

to terminate.

UnkillableStepTimeoutは、プロセスが終了するまで待機する時間を指定します。

See the "man slurm.conf" for more information about these parameters.

これらのパラメーターの詳細については、「man slurm.conf」を参照してください。

Why are my resource limits not propagated?

リソース制限が反映されないのはなぜですか?

When the srun command executes, it captures the

resource limits in effect at submit time on the node where srun executes.

srunコマンドが実行されると、srunが実行されるノードでの送信時に有効なリソース制限を取得します。

These limits are propagated to the allocated nodes before initiating the

user's job.

これらの制限は、ユーザーのジョブを開始する前に、割り当てられたノードに伝達されます。

The Slurm daemons running on the allocated nodes then try to establish

identical resource limits for the job being initiated.

割り当てられたノードで実行されているSlurmデーモンは、開始されているジョブに対して同一のリソース制限を確立しようとします。

There are several possible reasons for not being able to establish those

resource limits.

これらのリソース制限を確立できない理由はいくつか考えられます。

- The hard resource limits applied to Slurm's slurmd daemon are lower

than the user's soft resources limits on the submit host.

Slurmのslurmdデーモンに適用されるハードリソース制限は、サブミットホスト上のユーザーのソフトリソース制限よりも低くなっています。

Typically the slurmd daemon is initiated by the init daemon with the operating system default limits.

通常、slurmdデーモンは、オペレーティングシステムのデフォルトの制限でinitデーモンによって開始されます。

This may be addressed either through use of the ulimit command in the /etc/sysconfig/slurm file or enabling PAM in Slurm.

これは、/ etc / sysconfig / slurmファイルでulimitコマンドを使用するか、SlurmでPAMを有効にすることで対処できます。 - The user's hard resource limits on the allocated node are lower than

the same user's soft hard resource limits on the node from which the

job was submitted.

割り当てられたノード上のユーザーのハードリソース制限は、ジョブの送信元のノード上の同じユーザーのソフトハードリソース制限よりも低くなっています。

It is recommended that the system administrator establish uniform hard resource limits for users on all nodes within a cluster to prevent this from occurring.

システム管理者は、クラスタ内のすべてのノードのユーザーに対して、これが発生しないようにハードリソース制限を統一することをお勧めします。 - PropagateResourceLimits or PropagateResourceLimitsExcept parameters are

configured in slurm.conf and avoid propagation of specified limits.

PropagateResourceLimitsまたはPropagateResourceLimitsExceptパラメータはslurm.confで設定され、指定された制限の伝播を回避します。

NOTE: This may produce the error message "Can't propagate RLIMIT_...".

注:これにより、「RLIMIT _...を伝播できません」というエラーメッセージが表示される場合があります。

The error message is printed only if the user explicitly specifies that

the resource limit should be propagated or the srun command is running

with verbose logging of actions from the slurmd daemon (e.g. "srun -d6 ...").

エラーメッセージが表示されるのは、リソース制限を伝達する必要があることをユーザーが明示的に指定した場合、またはslurmdデーモンからのアクションの詳細なログを使用してsrunコマンドが実行されている場合のみです(「srun -d6 ...」など)。

Why is my job not running?

なぜ私の仕事が実行されないのですか?

The answer to this question depends on a lot of factors. The main one is which

scheduler is used by Slurm. Executing the command

この質問への答えは、多くの要因に依存します。主なものは、Slurmが使用するスケジューラーです。コマンドを実行する

scontrol show config | grep SchedulerType

will supply this information. If the scheduler type is builtin, then

jobs will be executed in the order of submission for a given partition.

この情報を提供します。スケジューラタイプが組み込みの場合、ジョブは指定されたパーティションの送信順に実行されます。

Even if

resources are available to initiate your job immediately, it will be deferred

until no previously submitted job is pending.

リソースを使用してジョブをすぐに開始できる場合でも、以前に送信されたジョブが保留状態になるまで、リソースは延期されます。

If the scheduler type is backfill,

then jobs will generally be executed in the order of submission for a given partition

with one exception: later submitted jobs will be initiated early if doing so does

not delay the expected execution time of an earlier submitted job.

スケジューラのタイプがバックフィルの場合、ジョブは通常、1つの例外を除いて、指定されたパーティションのサブミットの順序で実行されます。先にサブミットされたジョブの予想実行時間を遅らせない場合、後でサブミットされたジョブは早期に開始されます。

In order for

backfill scheduling to be effective, users' jobs should specify reasonable time

limits.

バックフィルのスケジュールを効果的にするには、ユーザーのジョブで適切な時間制限を指定する必要があります。

If jobs do not specify time limits, then all jobs will receive the same

time limit (that associated with the partition), and the ability to backfill schedule

jobs will be limited.

ジョブに時間制限が指定されていない場合、すべてのジョブが同じ時間制限(パーティションに関連付けられている時間制限)を受け取り、スケジュールジョブをバックフィルする機能が制限されます。

The backfill scheduler does not alter job specifications

of required or excluded nodes, so jobs which specify nodes will substantially

reduce the effectiveness of backfill scheduling.

バックフィルスケジューラは、必須または除外されたノードのジョブ仕様を変更しないため、ノードを指定するジョブは、バックフィルスケジューリングの効率を大幅に低下させます。

See the

backfill section for more details. For any scheduler, you can check priorities

of jobs using the command scontrol show job.

詳細については、バックフィルのセクションを参照してください。どのスケジューラーでも、コマンドscontrol show jobを使用してジョブの優先順位を確認できます。

Other reasons can include waiting for resources, memory, qos, reservations, etc.

その他の理由には、リソース、メモリ、QoS、予約などの待機が含まれます。

As a guideline, issue an scontrol show job <jobid>

and look at the field State and Reason to investigate the cause.

ガイドラインとして、scontrol showジョブを発行します そして、原因を調査するためにフィールドの状態と理由を見てください。

Why does the srun --overcommit option not permit multiple jobs

to run on nodes?

srun --overcommitオプションが複数のジョブのノードでの実行を許可しないのはなぜですか?

The --overcommit option is a means of indicating that a job or job step is willing

to execute more than one task per processor in the job's allocation.

--overcommitオプションは、ジョブまたはジョブステップが、ジョブの割り当てでプロセッサごとに複数のタスクを実行する意思があることを示す手段です。

For example,

consider a cluster of two processor nodes.

たとえば、2つのプロセッサノードのクラスタを考えます。

The srun execute line may be something

of this sort

srun実行行はこのようなものかもしれません

srun --ntasks=4 --nodes=1 a.out

This will result in not one, but two nodes being allocated so that each of the four

tasks is given its own processor.

これにより、1つではなく2つのノードが割り当てられ、4つのタスクのそれぞれに独自のプロセッサが割り当てられます。

Note that the srun --nodes option specifies

a minimum node count and optionally a maximum node count.

srun --nodesオプションは、最小ノード数とオプションで最大ノード数を指定することに注意してください。

A command line of

コマンドライン

srun --ntasks=4 --nodes=1-1 a.out

would result in the request being rejected.

リクエストは拒否されます。

If the --overcommit option

is added to either command line, then only one node will be allocated for all

four tasks to use.

--overcommitオプションをいずれかのコマンドラインに追加すると、使用する4つのタスクすべてに1つのノードのみが割り当てられます。

More than one job can execute simultaneously on the same compute resource

(e.g. CPU) through the use of srun's --oversubscribe option in

conjunction with the OverSubscribe parameter in Slurm's partition

configuration.

Slurmのパーティション構成でOverSubscribeパラメータと組み合わせてsrunの--oversubscribeオプションを使用することにより、複数のジョブを同じコンピューティングリソース(CPUなど)で同時に実行できます。

See the man pages for srun and slurm.conf for more information.

詳細については、srunおよびslurm.confのマニュアルページを参照してください。

Why is my job killed prematurely?

なぜ私の仕事は時期尚早に殺されるのですか?

Slurm has a job purging mechanism to remove inactive jobs (resource allocations)

before reaching its time limit, which could be infinite.

Slurmには、時間制限に達する前に非アクティブなジョブ(リソース割り当て)を削除するジョブパージメカニズムがあります。

This inactivity time limit is configurable by the system administrator.

この非アクティブ時間制限は、システム管理者が構成できます。

You can check its value with the command

次のコマンドで値を確認できます

scontrol show config | grep InactiveLimit

The value of InactiveLimit is in seconds.

InactiveLimitの値は秒単位です。

A zero value indicates that job purging is disabled.

ゼロの値は、ジョブのパージが無効であることを示します。

A job is considered inactive if it has no active job steps or if the srun

command creating the job is not responding.

アクティブなジョブステップがない場合、またはジョブを作成するsrunコマンドが応答しない場合、ジョブは非アクティブであると見なされます。

In the case of a batch job, the srun command terminates after the job script

is submitted.

バッチジョブの場合、ジョブスクリプトが送信されると、srunコマンドは終了します。

Therefore batch job pre- and post-processing is limited to the InactiveLimit.

したがって、バッチジョブの前処理と後処理はInactiveLimitに制限されます。

Contact your system administrator if you believe the InactiveLimit value

should be changed.

InactiveLimit値を変更する必要があると思われる場合は、システム管理者に連絡してください。

Why are my srun options ignored?

srunオプションが無視されるのはなぜですか?

Everything after the command srun is

examined to determine if it is a valid option for srun.

コマンドsrunの後のすべてが検査され、それがsrunの有効なオプションであるかどうかが判別されます。

The first

token that is not a valid option for srun is considered the command

to execute and everything after that is treated as an option to

the command. For example:

srunの有効なオプションではない最初のトークンは、実行するコマンドと見なされ、その後のすべてはコマンドのオプションとして扱われます。例えば:

srun -N2 hostname -pdebug

srun processes "-N2" as an option to itself.

srunはそれ自身のオプションとして「-N2」を処理します。

"hostname" is the

command to execute and "-pdebug" is treated as an option to the

hostname command.

「hostname」は実行するコマンドで、「-pdebug」はホスト名コマンドのオプションとして扱われます。

This will change the name of the computer

on which Slurm executes the command - Very bad, Don't run

this command as user root!

これにより、Slurmがコマンドを実行するコンピューターの名前が変更されます-非常に悪い。ユーザーrootとしてこのコマンドを実行しないでください。

Why is the Slurm backfill scheduler not starting my job?

Slurmバックフィルスケジューラがジョブを開始しないのはなぜですか?

The most common problem is failing to set job time limits.

最も一般的な問題は、ジョブの時間制限を設定できないことです。

If all jobs have

the same time limit (for example the partition's time limit), then backfill

will not be effective.

すべてのジョブに同じ制限時間(たとえば、パーティションの制限時間)がある場合、バックフィルは有効になりません。

Note that partitions can have both default and maximum

time limits, which can be helpful in configuring a system for effective

backfill scheduling.

パーティションにはデフォルトと最大の両方の時間制限を設定できることに注意してください。これは、効果的なバックフィルスケジューリングのためにシステムを構成するのに役立ちます。

In addition, there are a multitude of backfill scheduling parameters

which can impact which jobs are considered for backfill scheduling, such

as the maximum number of jobs tested per user.

さらに、ユーザーごとにテストされるジョブの最大数など、バックフィルスケジューリングの対象となるジョブに影響を与える可能性のある多数のバックフィルスケジューリングパラメーターがあります。

For more information see

the slurm.conf man page and check the configuration of SchedulingParameters

on your system.

詳細については、slurm.confのマニュアルページを参照し、システムのSchedulingParametersの設定を確認してください。

How can I run multiple jobs from within a

single script?

単一のスクリプト内から複数のジョブを実行するにはどうすればよいですか?

A Slurm job is just a resource allocation.

Slurmジョブは単なるリソース割り当てです。

You can execute many

job steps within that allocation, either in parallel or sequentially.

その割り当て内の多くのジョブステップを並列または順次に実行できます。

Some jobs actually launch thousands of job steps this way.

一部のジョブは、実際にこの方法で何千ものジョブステップを起動します。

The job

steps will be allocated nodes that are not already allocated to

other job steps.

ジョブステップには、他のジョブステップにまだ割り当てられていないノードが割り当てられます。

This essentially provides a second level of resource

management within the job for the job steps.

これは基本的に、ジョブステップのジョブ内で第2レベルのリソース管理を提供します。

How can I run a job within an existing

job allocation?

既存のジョブ割り当て内でジョブを実行するにはどうすればよいですか?

There is an srun option --jobid that can be used to specify

a job's ID.

ジョブのIDを指定するために使用できるsrunオプション--jobidがあります。

For a batch job or within an existing resource allocation, the

environment variable SLURM_JOB_ID has already been defined,

so all job steps will run within that job allocation unless

otherwise specified.

バッチジョブの場合、または既存のリソース割り当て内では、環境変数SLURM_JOB_IDがすでに定義されているため、特に指定しない限り、すべてのジョブステップはそのジョブ割り当て内で実行されます。

The one exception to this is when submitting batch jobs.

これに対する1つの例外は、バッチジョブを送信する場合です。

When a batch job is submitted from within an existing batch job,

it is treated as a new job allocation request and will get a

new job ID unless explicitly set with the --jobid option.

既存のバッチジョブ内からバッチジョブが送信されると、それは新しいジョブ割り当て要求として扱われ、-jobidオプションで明示的に設定されていない限り、新しいジョブIDを取得します。

If you specify that a batch job should use an existing allocation,

that job allocation will be released upon the termination of

that batch job.

バッチジョブで既存の割り当てを使用するように指定した場合、そのジョブの割り当ては、そのバッチジョブの終了時に解放されます。

How does Slurm establish the environment

for my job?

Slurmは私の仕事のための環境をどのように確立しますか?

Slurm processes are not run under a shell, but directly exec'ed

by the slurmd daemon (assuming srun is used to launch

the processes).

Slurmプロセスはシェルの下では実行されませんが、slurmdデーモンによって直接実行されます(プロセスの起動にsrunが使用されると想定)。

The environment variables in effect at the time the srun command

is executed are propagated to the spawned processes.

srunコマンドの実行時に有効な環境変数は、生成されたプロセスに伝達されます。

The ~/.profile and ~/.bashrc scripts are not executed

as part of the process launch.

〜/ .profileおよび〜/ .bashrcスクリプトは、プロセスの起動の一部として実行されません。

You can also look at the --export option of

srun and sbatch.

srunとsbatchの--exportオプションも確認できます。

See man pages for details.

詳細については、manページを参照してください。

How can I get shell prompts in interactive

mode?

対話モードでシェルプロンプトを取得するにはどうすればよいですか?

srun --pty bash -i

Srun's --pty option runs task zero in pseudo terminal mode.

Srunの--ptyオプションは、タスク0を疑似ターミナルモードで実行します。

Bash's -i option tells it to run in interactive mode (with prompts).

Bashの-iオプションは、対話モード(プロンプト付き)で実行するように指示します。

You can also configure SallocDefaultCommand in slurm.conf

to automatically launch a shell, e.g.:

slurm.confでSallocDefaultCommandを設定して、シェルを自動的に起動することもできます。例:

SallocDefaultCommand="srun -n1 -N1 --mem-per-cpu=0 --pty --preserve-env --cpu-bind=no --mpi=none $SHELL"

And then run salloc directly which will provide you an allocation with

an interactive shell console.

次に、sallocを直接実行して、対話型シェルコンソールで割り当てを行います。

How can I get the task ID in the output

or error file name for a batch job?

バッチジョブの出力またはエラーファイル名でタスクIDを取得するにはどうすればよいですか?

If you want separate output by task, you will need to build a script

containing this specification. For example:

タスクごとに個別の出力が必要な場合は、この仕様を含むスクリプトを作成する必要があります。例えば:

$ cat test #!/bin/sh echo begin_test srun -o out_%j_%t hostname $ sbatch -n7 -o out_%j test sbatch: Submitted batch job 65541 $ ls -l out* -rw-rw-r-- 1 jette jette 11 Jun 15 09:15 out_65541 -rw-rw-r-- 1 jette jette 6 Jun 15 09:15 out_65541_0 -rw-rw-r-- 1 jette jette 6 Jun 15 09:15 out_65541_1 -rw-rw-r-- 1 jette jette 6 Jun 15 09:15 out_65541_2 -rw-rw-r-- 1 jette jette 6 Jun 15 09:15 out_65541_3 -rw-rw-r-- 1 jette jette 6 Jun 15 09:15 out_65541_4 -rw-rw-r-- 1 jette jette 6 Jun 15 09:15 out_65541_5 -rw-rw-r-- 1 jette jette 6 Jun 15 09:15 out_65541_6 $ cat out_65541 begin_test $ cat out_65541_2 tdev2

Can the make command

utilize the resources allocated to a Slurm job?

makeコマンドはSlurmジョブに割り当てられたリソースを利用できますか?

Yes. There is a patch available for GNU make version 3.81

available as part of the Slurm distribution in the file

contribs/make-3.81.slurm.patch. For GNU make version 4.0 you

can use the patch in the file contribs/make-4.0.slurm.patch.

はい。ファイルcontribs / make-3.81.slurm.patchのSlurmディストリビューションの一部として利用可能なGNU makeバージョン3.81で利用可能なパッチがあります。GNU makeバージョン4.0の場合、ファイルcontribs / make-4.0.slurm.patchでパッチを使用できます。

This patch will use Slurm to launch tasks across a job's current resource

allocation.

このパッチは、Slurmを使用して、ジョブの現在のリソース割り当て全体でタスクを起動します。

Depending upon the size of modules to be compiled, this may

or may not improve performance.

コンパイルするモジュールのサイズによっては、パフォーマンスが向上する場合と向上しない場合があります。

If most modules are thousands of lines

long, the use of additional resources should more than compensate for the

overhead of Slurm's task launch.

ほとんどのモジュールが数千行の長さである場合、追加のリソースを使用することで、Slurmのタスク起動のオーバーヘッドを十分に補うことができます。

Use with make's -j option within an

existing Slurm allocation.

既存のSlurm割り当て内でmakeの-jオプションを使用します。

Outside of a Slurm allocation, make's behavior

will be unchanged.

Slurm割り当て以外では、makeの動作は変更されません。

Can tasks be launched with a remote (pseudo)

terminal?

リモート(疑似)端末でタスクを起動できますか?

You have several ways to do so, the recommended ones are the following:

これにはいくつかの方法がありますが、推奨される方法は次のとおりです。

The simplest method is to make use of srun's --pty option,

(e.g. srun --pty bash -i).

最も簡単な方法は、srunの--ptyオプションを使用することです(例:srun --pty bash -i)。

Srun's --pty option runs task zero in pseudo terminal mode.

Srunの--ptyオプションは、タスク0を疑似ターミナルモードで実行します。

Bash's

-i option instructs it to run in interactive mode (with prompts).

Bashの-iオプションは、対話モード(プロンプト付き)で実行するように指示します。

In addition to that method you have the option to define the

SallocDefaultCommand to run a task in pseudo terminal mode directly,

so you get the prompt just invoking salloc:

その方法に加えて、タスクを疑似端末モードで直接実行するSallocDefaultCommandを定義するオプションがあるため、sallocを呼び出すだけでプロンプトが表示されます。

SallocDefaultCommand="srun -n1 -N1 --mem-per-cpu=0 --pty --preserve-env --cpu-bind=no --mpi=none $SHELL"

Finally you can make use of X11 feature and run a graphical terminal.

(e.g. srun xterm).

最後に、X11機能を利用してグラフィカル端末を実行できます。(例:srun xterm)。

What does "srun: Force Terminated job"

indicate?

「srun:Force Terminated job」は何を示していますか?

The srun command normally terminates when the standard output and

error I/O from the spawned tasks end.

通常、srunコマンドは、生成されたタスクからの標準出力とエラーI / Oが終了すると終了します。

This does not necessarily

happen at the same time that a job step is terminated.

これは、ジョブステップの終了と同時に発生するとは限りません。

For example,

a file system problem could render a spawned task non-killable

at the same time that I/O to srun is pending.

たとえば、ファイルシステムの問題により、srunするI / Oが保留されているときに、生成されたタスクを強制終了できなくなる可能性があります。

Alternately a network

problem could prevent the I/O from being transmitted to srun.

または、ネットワークの問題により、I / Oがsrunに送信されない場合があります。

In any event, the srun command is notified when a job step is

terminated, either upon reaching its time limit or being explicitly

killed.

いずれの場合も、ジョブステップが制限時間に達するか、明示的に強制終了されると、ジョブステップが終了すると、srunコマンドに通知されます。

If the srun has not already terminated, the message

"srun: Force Terminated job" is printed.

srunがまだ終了していない場合は、「srun:Force Terminated job」というメッセージが出力されます。

If the job step's I/O does not terminate in a timely fashion

thereafter, pending I/O is abandoned and the srun command

exits.

その後、ジョブステップのI / Oが適時に終了しない場合、保留中のI / Oは破棄され、srunコマンドは終了します。

What does this mean:

"srun: First task exited 30s ago"

followed by "srun Job Failed"?

これはどういう意味ですか:「srun:最初のタスクは30秒前に終了しました」に続いて「srun Job Failed」

The srun command monitors when tasks exit. By default, 30 seconds

after the first task exists, the job is killed.

srunコマンドは、タスクがいつ終了するかを監視します。デフォルトでは、最初のタスクが存在してから30秒後に、ジョブは強制終了されます。

This typically indicates some type of job failure and continuing

to execute a parallel job when one of the tasks has exited is

not normally productive.

これは通常、ある種のジョブの失敗を示し、タスクの1つが終了したときに並列ジョブの実行を継続しても通常は生産的ではありません。

This behavior can be changed using srun's

--wait=<time> option to either change the timeout

period or disable the timeout altogether. See srun's man page

for details.

この動作は、srunの--wait =を使用して変更できます。タイムアウト期間を変更するか、タイムアウトを完全に無効にするオプション。詳細については、srunのmanページを参照してください。

Why is my MPI job failing due to the

locked memory (memlock) limit being too low?

ロックされたメモリ(memlock)の制限が低すぎるためにMPIジョブが失敗するのはなぜですか?

By default, Slurm propagates all of your resource limits at the

time of job submission to the spawned tasks.

デフォルトでは、Slurmはジョブの送信時に、生成されたタスクにすべてのリソース制限を伝達します。

This can be disabled by specifically excluding the propagation of

specific limits in the slurm.conf file.

これは、slurm.confファイルで特定の制限の伝播を明確に除外することで無効にできます。

For example

PropagateResourceLimitsExcept=MEMLOCK might be used to

prevent the propagation of a user's locked memory limit from a

login node to a dedicated node used for his parallel job.

たとえば、PropagateResourceLimitsExcept = MEMLOCKを使用して、ユーザーのロックされたメモリ制限が、ログインノードから並列ジョブに使用される専用ノードに伝達されないようにすることができます。

If the user's resource limit is not propagated, the limit in

effect for the slurmd daemon will be used for the spawned job.

ユーザーのリソース制限が伝搬されない場合、slurwnデーモンに有効な制限が、生成されたジョブに使用されます。

A simple way to control this is to ensure that user root has a

sufficiently large resource limit and ensuring that slurmd takes

full advantage of this limit.

これを制御する簡単な方法は、ユーザーrootに十分なリソース制限があることを確認し、slurmdがこの制限を最大限に活用できるようにすることです。

For example, you can set user root's

locked memory limit ulimit to be unlimited on the compute nodes (see

"man limits.conf") and ensuring that slurmd takes

full advantage of this limit (e.g. by adding "LimitMEMLOCK=infinity"

to your systemd's slurmd.service file).

たとえば、ユーザールートのロックされたメモリ制限ulimitを計算ノードで無制限に設定し(「man limits.conf」を参照)、slurmdがこの制限を最大限に活用できるようにします(たとえば、systemdの「LimitMEMLOCK = infinity」を追加することにより) slurmd.serviceファイル)。

It may also be desirable to lock

the slurmd daemon's memory to help ensure that it keeps responding if memory

swapping begins.

また、slurmdデーモンのメモリをロックして、メモリスワッピングが開始された場合にデーモンが応答し続けることを保証することが望ましい場合もあります。

A sample /etc/sysconfig/slurm which can be read from

systemd is shown below.

systemdから読み取ることができるサンプル/ etc / sysconfig / slurmを以下に示します。

Related information about PAM is also available.

PAMに関する関連情報も利用できます。

# # Example /etc/sysconfig/slurm # # Memlocks the slurmd process's memory so that if a node # starts swapping, the slurmd will continue to respond SLURMD_OPTIONS="-M"

Why is my batch job that launches no

job steps being killed?

ジョブステップを起動しないバッチジョブが強制終了されるのはなぜですか?

Slurm has a configuration parameter InactiveLimit intended

to kill jobs that do not spawn any job steps for a configurable

period of time.

Slurmには、構成可能な期間ジョブステップを生成しないジョブを強制終了することを目的とした構成パラメーターInactiveLimitがあります。

Your system administrator may modify the InactiveLimit

to satisfy your needs.

システム管理者は、必要に応じてInactiveLimitを変更できます。

Alternately, you can just spawn a job step

at the beginning of your script to execute in the background.

または、スクリプトの最初にジョブステップを生成して、バックグラウンドで実行することもできます。

It

will be purged when your script exits or your job otherwise terminates.

スクリプトが終了するか、ジョブが終了するとパージされます。

A line of this sort near the beginning of your script should suffice:

スクリプトの冒頭付近にあるこの種の行で十分です:

srun -N1 -n1 sleep 999999 &

How do I run specific tasks on certain nodes

in my allocation?

割り当ての特定のノードで特定のタスクを実行するにはどうすればよいですか?

One of the distribution methods for srun '-m

or --distribution' is 'arbitrary'.

srun '-mまたは--distribution'の配布方法の1つは「任意」です。

This means you can tell Slurm to

layout your tasks in any fashion you want.

つまり、タスクを任意の方法でレイアウトするようにSlurmに指示できます。

For instance if I had an

allocation of 2 nodes and wanted to run 4 tasks on the first node and

1 task on the second and my nodes allocated from SLURM_JOB_NODELIST

where tux[0-1] my srun line would look like this:

たとえば、2つのノードの割り当てがあり、最初のノードで4つのタスクを実行し、2番目のノードで1つのタスクを実行したい場合、tux [0-1]のSLURM_JOB_NODELISTから割り当てられたノードでは、srun行は次のようになります。

srun -n5 -m arbitrary -w tux[0,0,0,0,1] hostname

srun -n5 -m任意-w tux [0,0,0,0,1]ホスト名

If I wanted something similar but wanted the third task to be on tux 1

I could run this:

同様のものが必要だが、3番目のタスクをtux 1にしたい場合は、次のように実行できます。

srun -n5 -m arbitrary -w tux[0,0,1,0,0] hostname

srun -n5 -m任意-w tux [0,0,1,0,0]ホスト名

Here is a simple Perl script named arbitrary.pl that can be ran to easily lay

out tasks on nodes as they are in SLURM_JOB_NODELIST.

以下は、arrunary.plという名前のシンプルなPerlスクリプトで、SLURM_JOB_NODELISTにあるノードにタスクを簡単にレイアウトするために実行できます。

#!/usr/bin/perl

my @tasks = split(',', $ARGV[0]);

my @nodes = `scontrol show hostnames $SLURM_JOB_NODELIST`;

my $node_cnt = $#nodes + 1;

my $task_cnt = $#tasks + 1;

if ($node_cnt < $task_cnt) {

print STDERR "ERROR: You only have $node_cnt nodes, but requested layout on $task_cnt nodes.\n";

$task_cnt = $node_cnt;

}

my $cnt = 0;

my $layout;

foreach my $task (@tasks) {

my $node = $nodes[$cnt];

last if !$node;

chomp($node);

for(my $i=0; $i < $task; $i++) {

$layout .= "," if $layout;

$layout .= "$node";

}

$cnt++;

}

print $layout;

We can now use this script in our srun line in this fashion.

これで、このスクリプトをこの方法でsrun行で使用できます。

srun -m arbitrary -n5 -w `arbitrary.pl 4,1` -l hostname

srun -m任意-n5 -w `arbitrary.pl 4,1` -lホスト名

This will layout 4 tasks on the first node in the allocation and 1

task on the second node.

これにより、割り当ての最初のノードに4つのタスクが配置され、2番目のノードに1つのタスクが配置されます。

How can I temporarily prevent a job from running

(e.g. place it into a hold state)?

ジョブの実行を一時的に防ぐにはどうすればよいですか(たとえば、ジョブをホールド状態にするなど)?

The easiest way to do this is to change a job's earliest begin time

(optionally set at job submit time using the --begin option).

これを行う最も簡単な方法は、ジョブの最も早い開始時刻を変更することです(オプションで、ジョブの送信時に--beginオプションを使用して設定します)。

The example below places a job into hold state (preventing its initiation

for 30 days) and later permitting it to start now.

以下の例では、ジョブを保留状態(30日間は開始を禁止)にし、後で今すぐ開始することを許可しています。

$ scontrol update JobId=1234 StartTime=now+30days ... later ... $ scontrol update JobId=1234 StartTime=now

Why are jobs not getting the appropriate

memory limit?

ジョブが適切なメモリ制限を取得しないのはなぜですか?

This is probably a variation on the locked memory limit

problem described above.

これはおそらく、上記のロックされたメモリ制限の問題のバリエーションです。

Use the same solution for the AS (Address Space), RSS (Resident Set Size),

or other limits as needed.

AS(アドレススペース)、RSS(常駐セットサイズ)、または必要に応じて他の制限に対して同じソリューションを使用します。

Is an archive available of messages posted to

the slurm-users mailing list?

slurm-usersメーリングリストに投稿されたメッセージのアーカイブはありますか?

Yes, it is at

http://groups.google.com/group/slurm-users

はい、http://groups.google.com/group/slurm-usersにあります

Can I change my job's size after it has started

running?

実行開始後にジョブのサイズを変更できますか?

Slurm supports the ability to both increase and decrease the size of jobs.

Slurmは、ジョブのサイズを拡大および縮小する機能の両方をサポートしています。

While the size of a pending job may be changed with few restrictions, several

significant restrictions apply to changing the size of a running job, as noted

below:

保留中のジョブのサイズはわずかな制限で変更される可能性がありますが、以下に示すように、実行中のジョブのサイズの変更にはいくつかの重要な制限が適用されます。

- Requesting fewer hardware resources, and changing partition, qos,

reservation, licenses, etc. is only allowed for pending jobs.

要求するハードウェアリソースを減らし、パーティション、QoS、予約、ライセンスなどを変更することは、保留中のジョブに対してのみ許可されます。 - Job(s) changing size must not be in a suspended state, including jobs

suspended for gang scheduling. The jobs must be in a state of pending or

running.

サイズを変更するジョブは、ギャングスケジューリングのために一時停止されたジョブを含め、一時停止状態であってはなりません。ジョブは保留中または実行中の状態でなければなりません。 - Job expansion for running jobs is disabled by default.

実行中のジョブのジョブ拡張は、デフォルトでは無効になっています。

Site administrators can enable this capability by setting SchedulerParameters=permit_job_expansion in slurm.conf

サイト管理者は、slurm.confでSchedulerParameters = permit_job_expansionを設定することにより、この機能を有効にできます

Use the scontrol command to change a job's size either by specifying

a new node count (NumNodes=) for the job or identify the specific nodes

(NodeList=) that you want the job to retain.

scontrolコマンドを使用して、ジョブの新しいノード数(NumNodes =)を指定するか、ジョブに保持する特定のノード(NodeList =)を指定して、ジョブのサイズを変更します。

Any job steps running on the nodes which are relinquished by the job will be

killed unless initiated with the --no-kill option.

--no-killオプションで開始しない限り、ジョブによって解放されたノードで実行されているジョブステップはすべて強制終了されます。

After the job size is changed, some environment variables created by Slurm

containing information about the job's environment will no longer be valid and

should either be removed or altered (e.g. SLURM_JOB_NODES, SLURM_JOB_NODELIST and

SLURM_NTASKS).

ジョブサイズが変更されると、ジョブの環境に関する情報を含むSlurmによって作成された一部の環境変数は無効になり、削除または変更する必要があります(SLURM_JOB_NODES、SLURM_JOB_NODELIST、SLURM_NTASKSなど)。

The scontrol command will generate a script that can be executed to

reset local environment variables.

scontrolコマンドは、ローカル環境変数をリセットするために実行できるスクリプトを生成します。

You must retain the SLURM_JOB_ID environment variable in order for the

srun command to gather information about the job's current state and

specify the desired node and/or task count in subsequent srun invocations.

srunコマンドがジョブの現在の状態に関する情報を収集し、後続のsrun呼び出しで目的のノードやタスクの数を指定できるように、SLURM_JOB_ID環境変数を保持する必要があります。

A new accounting record is generated when a job is resized, showing the job to

have been resubmitted and restarted at the new size.

ジョブのサイズが変更されると、新しいアカウンティングレコードが生成され、ジョブが再送信され、新しいサイズで再起動されたことが示されます。

An example is shown below.

以下に例を示します。

#!/bin/bash

srun my_big_job

scontrol update JobId=$SLURM_JOB_ID NumNodes=2

. slurm_job_${SLURM_JOB_ID}_resize.sh

srun -N2 my_small_job

rm slurm_job_${SLURM_JOB_ID}_resize.*

Increasing a job's size

ジョブのサイズを増やす

Directly increasing the size of a running job would adversely affect the

scheduling of pending jobs.

実行中のジョブのサイズを直接増やすと、保留中のジョブのスケジューリングに悪影響を及ぼします。

For the sake of fairness in job scheduling, expanding a running job requires

the user to submit a new job, but specify the option

--dependency=expand:<jobid>.

ジョブのスケジュールを公平にするために、実行中のジョブを展開するには、ユーザーが新しいジョブを送信する必要がありますが、オプション--dependency = expandを指定します。。

This option tells Slurm that the job, when scheduled, can be used to expand

the specified jobid.

このオプションは、スケジュールされたジョブを使用して、指定されたジョブIDを展開できることをSlurmに通知します。

Other job options would be used to identify the required resources

(e.g. task count, node count, node features, etc.).

他のジョブオプションは、必要なリソースを識別するために使用されます(タスク数、ノード数、ノード機能など)。

This new job's time limit will be automatically set to reflect the end time of

the job being expanded.

この新しいジョブの制限時間は、拡張されるジョブの終了時間を反映するように自動的に設定されます。

This new job's generic resources specification will be automatically set

equal to that of the job being merged to.

この新しいジョブの総称リソース仕様は、マージされるジョブの仕様に自動的に等しく設定されます。

This is due to the current Slurm

restriction of all nodes associated with a job needing to have the same

generic resource specification (i.e. a job can not have one GPU on one

node and two GPUs on another node), although this restriction may be removed

in the future.

これは、ジョブに関連付けられたすべてのノードの現在のSlurm制限によるものです。同じ汎用リソース指定が必要です(つまり、ジョブは1つのノードに1つのGPUと別のノードに2つのGPUを持つことはできません)。ただし、この制限は未来。

This restriction can pose some problems when both jobs can be

allocated resources on the same node, in which case the generic resources

allocated to the new job will be released.

この制限は、両方のジョブに同じノード上のリソースを割り当てることができる場合にいくつかの問題を引き起こす可能性があります。その場合、新しいジョブに割り当てられた汎用リソースが解放されます。

If the jobs are allocated resources

on different nodes, the generic resources associated with the resulting job

allocation after the merge will be consistent as expected.

ジョブに異なるノードのリソースが割り当てられている場合、マージ後のジョブの割り当てに関連する一般的なリソースは、期待どおりに一貫します。

Any licenses associated with the new job will be added to those available in

the job being merged to.

新しいジョブに関連付けられているライセンスは、マージされるジョブで使用可能なライセンスに追加されます。

Note that partition and Quality Of Service (QOS) limits will be applied

independently to the new job allocation so the expanded job may exceed size

limits configured for an individual job.

パーティションとサービスの品質(QOS)の制限は、新しいジョブの割り当てに個別に適用されるため、拡張されたジョブは、個々のジョブに構成されたサイズ制限を超える可能性があることに注意してください。

After the new job is allocated resources, merge that job's allocation

into that of the original job by executing:

新しいジョブにリソースが割り当てられたら、次のコマンドを実行して、そのジョブの割り当てを元のジョブの割り当てにマージします。

scontrol update jobid=<jobid> NumNodes=0

scontrol update jobid = NumNodes = 0

The jobid above is that of the job to relinquish its resources.

上記のジョブIDは、そのリソースを放棄するジョブのものです。

To provide more control over when the job expansion occurs, the resources are

not merged into the original job until explicitly requested.

ジョブの拡張が発生するタイミングをより詳細に制御するために、明示的に要求されるまで、リソースは元のジョブにマージされません。

These resources will be transferred to the original job and the scontrol

command will generate a script to reset variables in the second

job's environment to reflect its modified resource allocation (which would

be no resources).

これらのリソースは元のジョブに転送され、scontrolコマンドはスクリプトを生成して、2番目のジョブの環境で変数をリセットし、変更されたリソース割り当て(リソースがない)を反映します。

One would normally exit this second job at this point, since it has no

associated resources.

関連するリソースがないため、通常、この時点でこの2番目のジョブを終了します。

In order to generate a script to modify the environment variables for the

expanded job, execute:

拡張ジョブの環境変数を変更するスクリプトを生成するには、次を実行します。

scontrol update jobid=<jobid> NumNodes=ALL

scontrol update jobid = NumNodes = ALL

Then execute the script generated.

次に、生成されたスクリプトを実行します。

Note that this command does not change the original job's size, but only

generates the script to change its environment variables.

このコマンドは元のジョブのサイズを変更せず、環境変数を変更するスクリプトを生成するだけであることに注意してください。

Until the environment variables are modified (e.g. the job's node count,

CPU count, hostlist, etc.), any srun command will only consider the resources

in the original resource allocation.

環境変数(ジョブのノード数、CPU数、ホストリストなど)が変更されるまで、srunコマンドは元のリソース割り当てのリソースのみを考慮します。

Note that the original job may have active job steps at the time of its

expansion, but they will not be affected by the change.

元のジョブは展開時にアクティブなジョブステップを持っている可能性がありますが、変更による影響はありません。

An example of the procedure is shown below in which the original job

allocation waits until the second resource allocation request can be

satisfied.

手順の例を以下に示します。この場合、元のジョブ割り当ては、2番目のリソース割り当て要求が満たされるまで待機します。

The job requesting additional resources could also use the sbatch

command and permit the original job to continue execution at its initial size.

追加のリソースを要求するジョブは、sbatchコマンドを使用して、元のジョブが初期サイズで実行を継続できるようにすることもできます。

Note that the development of additional user tools to manage Slurm resource

allocations is planned in the future to make this process both simpler and

more flexible.

Slurmリソース割り当てを管理するための追加のユーザーツールの開発は、このプロセスをより簡単でより柔軟にするために、将来計画されていることに注意してください。

$ salloc -N4 -C haswell bash

salloc: Granted job allocation 65542

$ srun hostname

icrm1

icrm2

icrm3

icrm4

$ salloc -N4 -C knl,snc4,flat --dependency=expand:$SLURM_JOB_ID bash

salloc: Granted job allocation 65543

$ scontrol update jobid=$SLURM_JOB_ID NumNodes=0

To reset Slurm environment variables, execute

For bash or sh shells: . ./slurm_job_65543_resize.sh

For csh shells: source ./slurm_job_65543_resize.csh

$ exit

exit

salloc: Relinquishing job allocation 65543

$ scontrol update jobid=$SLURM_JOB_ID NumNodes=ALL

To reset Slurm environment variables, execute

For bash or sh shells: . ./slurm_job_65542_resize.sh

For csh shells: source ./slurm_job_65542_resize.csh

$ . ./slurm_job_${SLURM_JOB_ID}_resize.sh

$ srun hostname

icrm1

icrm2

icrm3

icrm4

icrm5

icrm6

icrm7

icrm8

$ exit

exit

salloc: Relinquishing job allocation 65542

Why is my MPICH2 or MVAPICH2 job not running with

Slurm? Why does the DAKOTA program not run with Slurm?

MPICH2またはMVAPICH2ジョブがSlurmで実行されないのはなぜですか?DAKOTAプログラムがSlurmで実行されないのはなぜですか?

The Slurm library used to support MPICH2 or MVAPICH2 references a variety of

symbols.

MPICH2またはMVAPICH2をサポートするために使用されるSlurmライブラリは、さまざまなシンボルを参照します。

If those symbols resolve to functions or variables in your program

rather than the appropriate library, the application will fail.

これらのシンボルが適切なライブラリではなくプログラム内の関数または変数に解決されると、アプリケーションは失敗します。

For example

DAKOTA, versions 5.1 and

older, contains a function named regcomp, which will get used rather

than the POSIX regex functions.

たとえば、DAKOTA、バージョン5.1以前には、POSIX regex関数ではなく使用されるregcompという名前の関数が含まれています。

Rename DAKOTA's function and

references from regcomp to something else to make it work properly.

DAKOTAの関数と参照の名前をregcompから別の名前に変更して、正しく機能するようにします。

Why does squeue (and "scontrol show

jobid") sometimes not display a job's estimated start time?

squeue(および「scontrol show jobid」)がジョブの推定開始時刻を表示しないことがあるのはなぜですか?

When the backfill scheduler is configured, it provides an estimated start time

for jobs that are candidates for backfill.

バックフィルスケジューラを構成すると、バックフィルの候補となるジョブの推定開始時間が提供されます。

Pending jobs with dependencies

will not have an estimate as it is difficult to predict what resources will

be available when the jobs they are dependent on terminate.

依存関係のある保留中のジョブは、依存しているジョブが終了したときに使用可能なリソースを予測することが難しいため、見積もりはありません。

Also note that

the estimate is better for jobs expected to start soon, as most running jobs

end before their estimated time.

また、ほとんどの実行中のジョブは推定時間より前に終了するため、推定はすぐに開始されることが予想されるジョブの方が優れていることにも注意してください。

There are other restrictions on backfill that

may apply. See the backfill section for more details.

適用される可能性のあるバックフィルには他にも制限があります。詳細については、バックフィルのセクションを参照してください。

How can I run an Ansys program with Slurm?

SlurmでAnsysプログラムを実行するにはどうすればよいですか?

If you are talking about an interactive run of the Ansys app, then you can use

this simple script (it is for Ansys Fluent):

Ansysアプリのインタラクティブな実行について話している場合は、次の簡単なスクリプトを使用できます(Ansys Fluent用です)。

$ cat ./fluent-srun.sh #!/usr/bin/env bash HOSTSFILE=.hostlist-job$SLURM_JOB_ID if [ "$SLURM_PROCID" == "0" ]; then srun hostname -f > $HOSTSFILE fluent -t $SLURM_NTASKS -cnf=$HOSTSFILE -ssh 3d rm -f $HOSTSFILE fi exit 0

To run an interactive session, use srun like this:

インタラクティブセッションを実行するには、次のようにsrunを使用します。

$ srun -n <tasks> ./fluent-srun.sh

How can a job in a complete or failed state be requeued?

完了または失敗した状態のジョブをどのように再キューイングできますか?

Slurm supports requeueing jobs in a done or failed state. Use the

command:

Slurmは、完了または失敗した状態のジョブの再キューイングをサポートしています。次のコマンドを使用します。

scontrol requeue job_id

The job will then be requeued back in the PENDING state and scheduled again.

その後、ジョブはPENDING状態で再度キューに入れられ、再度スケジュールされます。

See man(1) scontrol.

man(1)scontrolを参照してください。

Consider a simple job like this:

このような簡単な仕事を考えてみましょう:

$cat zoppo #!/bin/sh echo "hello, world" exit 10 $sbatch -o here ./zoppo Submitted batch job 10

The job finishes in FAILED state because it exits with

a non zero value.

ジョブはゼロ以外の値で終了するため、FAILED状態で終了します。

We can requeue the job back to

the PENDING state and the job will be dispatched again.

ジョブをPENDING状態に再キューイングすると、ジョブが再びディスパッチされます。

$ scontrol requeue 10

$ squeue

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)

10 mira zoppo david PD 0:00 1 (NonZeroExitCode)

$ squeue

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)

10 mira zoppo david R 0:03 1 alanz1

Slurm supports requeuing jobs in a hold state with the command:

Slurmは、次のコマンドを使用して、ホールド状態のジョブの再キューイングをサポートします。

'scontrol requeuehold job_id'

The job can be in state RUNNING, SUSPENDED, COMPLETED or FAILED

before being requeued.

ジョブは、キューに再登録される前に、RUNNING、SUSPENDED、COMPLETED、またはFAILEDの状態になる可能性があります。

$ scontrol requeuehold 10

$ squeue

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)

10 mira zoppo david PD 0:00 1 (JobHeldUser)

Slurm documentation refers to CPUs, cores and threads.

Slurmのドキュメントでは、CPU、コア、スレッドについて言及しています。

What exactly is considered a CPU?

正確には何がCPUと見なされますか?

If your nodes are configured with hyperthreading, then a CPU is equivalent

to a hyperthread.

ノードがハイパースレッディングで構成されている場合、CPUはハイパースレッドと同等です。

Otherwise a CPU is equivalent to a core.

それ以外の場合、CPUはコアと同等です。

You can determine if your nodes have more than one thread per core

using the command "scontrol show node" and looking at the values of

"ThreadsPerCore".

「scontrol show node」コマンドを使用して「ThreadsPerCore」の値を確認すると、ノードにコアごとに複数のスレッドがあるかどうかを確認できます。

Note that even on systems with hyperthreading enabled, the resources will

generally be allocated to jobs at the level of a core (see NOTE below).

ハイパースレッディングが有効になっているシステムでも、リソースは通常、コアのレベルでジョブに割り当てられることに注意してください(下記の注を参照)。

Two different jobs will not share a core except through the use of a partition

OverSubscribe configuration parameter.

2つの異なるジョブは、パーティションのOverSubscribe構成パラメーターを使用しない限り、コアを共有しません。

For example, a job requesting resources for three tasks on a node with

ThreadsPerCore=2 will be allocated two full cores.

たとえば、ThreadsPerCore = 2のノードで3つのタスクのリソースを要求するジョブには、2つのフルコアが割り当てられます。

Note that Slurm commands contain a multitude of options to control

resource allocation with respect to base boards, sockets, cores and threads.

Slurmコマンドには、ベースボード、ソケット、コア、スレッドに関するリソース割り当てを制御するための多数のオプションが含まれていることに注意してください。

(NOTE: An exception to this would be if the system administrator

configured SelectTypeParameters=CR_CPU and each node's CPU count without its

socket/core/thread specification.

(注:これに対する例外は、システム管理者がSelectTypeParameters = CR_CPUを構成し、各ノードのソケット/コア/スレッド指定なしのCPU数を構成した場合です。

In that case, each thread would be

independently scheduled as a CPU.

その場合、各スレッドは独立してCPUとしてスケジュールされます。

This is not a typical configuration.)

これは一般的な構成ではありません。)

What is the difference between the sbatch

and srun commands?

sbatchコマンドとsrunコマンドの違いは何ですか?

The srun command has two different modes of operation.

srunコマンドには、2つの異なる操作モードがあります。

First, if not run within

an existing job (i.e. not within a Slurm job allocation created by salloc or

sbatch), then it will create a job allocation and spawn an application.

まず、既存のジョブ内で実行されていない場合(つまり、sallocまたはsbatchによって作成されたSlurmジョブ割り当て内ではない場合)、ジョブ割り当てが作成され、アプリケーションが生成されます。

If run within an existing allocation, the srun command only spawns the

application.

既存の割り当て内で実行する場合、srunコマンドはアプリケーションのみを生成します。

For this question, we will only address the first mode of operation and compare

creating a job allocation using the sbatch and srun commands.

この質問では、最初の操作モードのみを取り上げ、sbatchコマンドとsrunコマンドを使用したジョブ割り当ての作成を比較します。

The srun command is designed for interactive use, with someone monitoring

the output.

srunコマンドはインタラクティブな使用のために設計されており、誰かが出力を監視しています。

The output of the application is seen as output of the srun command,

typically at the user's terminal.

アプリケーションの出力は、通常はユーザーの端末で、srunコマンドの出力と見なされます。

The sbatch command is designed to submit a script for later execution and its

output is written to a file.

sbatchコマンドは、後で実行するためにスクリプトを送信するように設計されており、その出力はファイルに書き込まれます。

Command options used in the job allocation are almost identical.

ジョブの割り当てで使用されるコマンドオプションはほとんど同じです。

The most noticeable difference in options is that the sbatch command supports

the concept of job arrays, while srun does not.

オプションの最も顕著な違いは、sbatchコマンドがジョブ配列の概念をサポートするのに対し、srunはサポートしないことです。

Another significant difference is in fault tolerance.

もう1つの大きな違いは、フォールトトレランスです。

Failures involving sbatch jobs typically result in the job being requeued

and executed again, while failures involving srun typically result in an

error message being generated with the expectation that the user will respond

in an appropriate fashion.

sbatchジョブに関連する障害では、通常、ジョブが再度キューに入れられて再度実行されますが、srunに関連する障害では、通常、ユーザーが適切に応答することを期待してエラーメッセージが生成されます。

Can squeue output be color coded?

squeueの出力を色分けできますか?

The squeue command output is not color coded, but other tools can be used to

add color. One such tool is ColorWrapper

(https://github.com/rrthomas/cw).

squeueコマンドの出力は色分けされていませんが、他のツールを使用して色を追加できます。そのようなツールの1つがColorWrapper(https://github.com/rrthomas/cw)です。

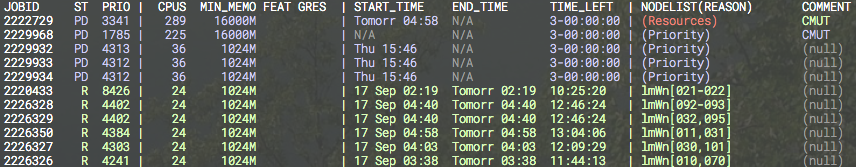

A sample ColorWrapper configuration file and output are shown below.

ColorWrapper設定ファイルのサンプルと出力を以下に示します。

path /bin:/usr/bin:/sbin:/usr/sbin:<env> usepty base green+ match red:default (Resources) match black:default (null) match black:cyan N/A regex cyan:default PD .*$ regex red:default ^\d*\s*C .*$ regex red:default ^\d*\s*CG .*$ regex red:default ^\d*\s*NF .*$ regex white:default ^JOBID.*

Can Slurm export an X11 display on an allocated compute node?

Slurmは割り当てられた計算ノードでX11ディスプレイをエクスポートできますか?

You can use the X11 builtin feature starting at version 17.11.

バージョン11.11以降のX11組み込み機能を使用できます。

It is enabled by setting PrologFlags=x11 in slurm.conf.

slurm.confでPrologFlags = x11を設定すると有効になります。

Other X11 plugins must be deactivated.

他のX11プラグインは無効にする必要があります。

Run it as shown:

次のように実行します。

$ ssh -X user@login1 $ srun -n1 --pty --x11 xclock

An alternative for older versions is to build and install an optional SPANK

plugin for that functionality.

古いバージョンの代替手段は、その機能用のオプションのSPANKプラグインをビルドしてインストールすることです。

Instructions to build and install the plugin

follow.

プラグインをビルドしてインストールする手順は次のとおりです。

This SPANK plugin will not work if used in combination with native X11

support so you must disable it compiling Slurm with --disable-x11.

このSPANKプラグインは、ネイティブX11サポートと組み合わせて使用すると機能しないため、-disable-x11でSlurmをコンパイルして無効にする必要があります。

This

plugin relies on openssh library and it provides features such as GSSAPI

support.

このプラグインはopensshライブラリに依存し、GSSAPIサポートなどの機能を提供します。

Update the Slurm installation path as needed:

必要に応じてSlurmインストールパスを更新します。

# It may be obvious, but don't forget the -X on ssh $ ssh -X alex@testserver.com # Get the plugin $ mkdir git $ cd git $ git clone https://github.com/hautreux/slurm-spank-x11.git $ cd slurm-spank-x11 # Manually edit the X11_LIBEXEC_PROG macro definition $ vi slurm-spank-x11.c $ vi slurm-spank-x11-plug.c $ grep "define X11_" slurm-spank-x11.c #define X11_LIBEXEC_PROG "/opt/slurm/17.02/libexec/slurm-spank-x11" $ grep "define X11_LIBEXEC_PROG" slurm-spank-x11-plug.c #define X11_LIBEXEC_PROG "/opt/slurm/17.02/libexec/slurm-spank-x11" # Compile $ gcc -g -o slurm-spank-x11 slurm-spank-x11.c $ gcc -g -I/opt/slurm/17.02/include -shared -fPIC -o x11.so slurm-spank-x11-plug.c # Install $ mkdir -p /opt/slurm/17.02/libexec $ install -m 755 slurm-spank-x11 /opt/slurm/17.02/libexec $ install -m 755 x11.so /opt/slurm/17.02/lib/slurm # Configure $ echo -e "optional x11.so" >> /opt/slurm/17.02/etc/plugstack.conf $ cd ~/tests # Run $ srun -n1 --pty --x11 xclock alex@node1's password:

Why is the srun --u/--unbuffered option adding

a carriage character return to my output?

srun --u /-unbufferedオプションがキャリッジリターンを出力に追加するのはなぜですか?

The libc library used by many programs internally buffers output rather than

writing it immediately.

多くのプログラムで使用されるlibcライブラリは、出力をすぐに書き込むのではなく、内部でバッファリングします。

This is done for performance reasons.

これは、パフォーマンス上の理由で行われます。

The only way to disable this internal buffering is to configure the program to

write to a pseudo terminal (PTY) rather than to a regular file.

この内部バッファリングを無効にする唯一の方法は、通常のファイルではなく疑似端末(PTY)に書き込むようにプログラムを構成することです。

This configuration causes some implementations of libc to prepend the

carriage return character before all line feed characters.

この構成により、libcの一部の実装では、すべての改行文字の前に復帰文字が付加されます。

Removing the carriage return character would result in desired formatting

in some instances, while causing bad formatting in other cases.

キャリッジリターン文字を削除すると、場合によっては適切なフォーマットになりますが、それ以外の場合はフォーマットが悪くなります。

In any case, Slurm is not adding the carriage return character, but displaying

the actual program's output.

いずれにせよ、Slurmは復帰文字を追加していませんが、実際のプログラムの出力を表示しています。

Why is sview not coloring/highlighting nodes

properly?

sviewがノードを適切に色付け/強調表示しないのはなぜですか?

sview color-coding is affected by the GTK theme.

sviewの色分けはGTKテーマの影響を受けます。

The node status grid

is made up of button widgets and certain GTK themes don't show the color

setting as desired.

ノードステータスグリッドはボタンウィジェットで構成されており、特定のGTKテーマは希望どおりに色設定を表示しません。

Changing GTK themes can restore proper color-coding.

GTKテーマを変更すると、適切な色分けが復元されます。

For Administrators

How is job suspend/resume useful?

ジョブの一時停止/再開はどのように役立ちますか?

Job suspend/resume is most useful to get particularly large jobs initiated

in a timely fashion with minimal overhead.

ジョブの一時停止/再開は、特に大きなジョブを最小限のオーバーヘッドでタイムリーに開始するのに最も役立ちます。

Say you want to get a full-system

job initiated.

システム全体のジョブを開始したいとします。

Normally you would need to either cancel all running jobs

or wait for them to terminate.

通常、実行中のすべてのジョブをキャンセルするか、ジョブが終了するまで待つ必要があります。

Canceling jobs results in the loss of

their work to that point from their beginning.

ジョブをキャンセルすると、最初からその時点までの作業が失われます。

Waiting for the jobs to terminate can take hours, depending upon your

system configuration.

システム構成によっては、ジョブが終了するまで数時間かかる場合があります。

A more attractive alternative is to suspend the

running jobs, run the full-system job, then resume the suspended jobs.

より魅力的な代替手段は、実行中のジョブを一時停止し、システム全体のジョブを実行してから、一時停止したジョブを再開することです。

This can easily be accomplished by configuring a special queue for

full-system jobs and using a script to control the process.

これは、フルシステムジョブ用の特別なキューを構成し、スクリプトを使用してプロセスを制御することで簡単に実現できます。

The script would stop the other partitions, suspend running jobs in those

partitions, and start the full-system partition.

スクリプトは他のパーティションを停止し、それらのパーティションで実行中のジョブを一時停止し、システム全体のパーティションを開始します。

The process can be reversed when desired.

必要に応じて、プロセスを逆にすることができます。

One can effectively gang schedule (time-slice) multiple jobs

using this mechanism, although the algorithms to do so can get quite

complex.

このメカニズムを使用すると、複数のジョブのスケジュール(タイムスライス)を効率的に連動させることができますが、そのためのアルゴリズムは非常に複雑になる可能性があります。

Suspending and resuming a job makes use of the SIGSTOP and SIGCONT

signals respectively, so swap and disk space should be sufficient to

accommodate all jobs allocated to a node, either running or suspended.

ジョブの一時停止と再開はそれぞれSIGSTOPシグナルとSIGCONTシグナルを使用するため、実行中または一時停止中のノードに割り当てられたすべてのジョブに対応するには、スワップ領域とディスク領域で十分です。

Why is a node shown in state

DOWN when the node has registered for service?

ノードがサービスに登録されているのに、ノードがDOWN状態で表示されるのはなぜですか?

The configuration parameter ReturnToService in slurm.conf

controls how DOWN nodes are handled.

slurm.confの構成パラメーターReturnToServiceは、DOWNノードの処理方法を制御します。

Set its value to one in order for DOWN nodes to automatically be

returned to service once the slurmd daemon registers

with a valid node configuration.

slurmdデーモンが有効なノード構成に登録されると、DOWNノードが自動的にサービスに戻るように、その値を1に設定します。

A value of zero is the default and results in a node staying DOWN

until an administrator explicitly returns it to service using

the command "scontrol update NodeName=whatever State=RESUME".

ゼロの値がデフォルトであり、管理者がコマンド「scontrol update NodeName = whatever State = RESUME」を使用して明示的にサービスに戻すまで、ノードはDOWNのままです。

See "man slurm.conf" and "man scontrol" for more

details.

詳細については、「man slurm.conf」および「man scontrol」を参照してください。

What happens when a node crashes?

ノードがクラッシュするとどうなりますか?

A node is set DOWN when the slurmd daemon on it stops responding

for SlurmdTimeout as defined in slurm.conf.

slurm.confで定義されているように、ノードのslurmdデーモンがSlurmdTimeoutの応答を停止すると、ノードはDOWNに設定されます。

The node can also be set DOWN when certain errors occur or the

node's configuration is inconsistent with that defined in slurm.conf.

特定のエラーが発生した場合、またはノードの構成がslurm.confで定義されたものと一致しない場合、ノードをDOWNに設定することもできます。

Any active job on that node will be killed unless it was submitted

with the srun option --no-kill.

そのノード上のアクティブなジョブは、srunオプション--no-killを使用して送信されない限り、強制終了されます。

Any active job step on that node will be killed.

そのノード上のアクティブなジョブステップはすべて強制終了されます。

See the slurm.conf and srun man pages for more information.

詳細については、slurm.confおよびsrunのmanページを参照してください。

How can I control the execution of multiple

jobs per node?

ノードごとに複数のジョブの実行を制御するにはどうすればよいですか?

There are two mechanisms to control this.

これを制御するメカニズムは2つあります。

If you want to allocate individual processors on a node to jobs,

configure SelectType=select/cons_res.

ノード上の個々のプロセッサをジョブに割り当てる場合は、SelectType = select / cons_resを構成します。

See Consumable Resources in Slurm

for details about this configuration.

この構成の詳細については、Slurmの消費可能なリソースを参照してください。

If you want to allocate whole nodes to jobs, configure

configure SelectType=select/linear.

ノード全体をジョブに割り当てる場合は、configure SelectType = select / linearを構成します。

Each partition also has a configuration parameter OverSubscribe

that enables more than one job to execute on each node.

各パーティションには、各ノードで複数のジョブを実行できるようにする構成パラメーターOverSubscribeもあります。

See man slurm.conf for more information about these

configuration parameters.

これらの構成パラメーターの詳細については、man slurm.confを参照してください。

When the Slurm daemon starts, it

prints "cannot resolve X plugin operations" and exits.

Slurmデーモンが起動すると、「Xプラグイン操作を解決できません」と出力して終了します。

What does this mean?

これは何を意味するのでしょうか?

This means that symbols expected in the plugin were

not found by the daemon.

これは、プラグインで予期されるシンボルがデーモンによって検出されなかったことを意味します。

This typically happens when the

plugin was built or installed improperly or the configuration

file is telling the plugin to use an old plugin (say from the

previous version of Slurm).

これは通常、プラグインが正しく構築またはインストールされていないか、構成ファイルがプラグインに古いプラグインを使用するように指示している場合に発生します(たとえば、Slurmの以前のバージョンから)。

Restart the daemon in verbose mode

for more information (e.g. "slurmctld -Dvvvvv").

詳細については、デーモンを詳細モードで再起動してください(例: "slurmctld -Dvvvvv")。

How can I exclude some users from pam_slurm?

一部のユーザーをpam_slurmから除外するにはどうすればよいですか?

CAUTION: Please test this on a test machine/VM before you actually do

this on your Slurm computers.

注意:実際にSlurmコンピューターでテストする前に、テストマシン/ VMでテストしてください。

Step 1. Make sure pam_listfile.so exists on your system.

手順1.システムにpam_listfile.soが存在することを確認します。

The following command is an example on Redhat 6:

次のコマンドはRedhat 6の例です。

ls -la /lib64/security/pam_listfile.so

Step 2. Create user list (e.g. /etc/ssh/allowed_users):

ステップ2.ユーザーリストを作成します(例:/ etc / ssh / allowed_users):

# /etc/ssh/allowed_users root myadmin

And, change file mode to keep it secret from regular users(Optional):

そして、ファイルモードを変更して、通常のユーザーからそれを秘密に保ちます(オプション):

chmod 600 /etc/ssh/allowed_users

NOTE: root is not necessarily listed on the allowed_users, but I

feel somewhat safe if it's on the list.

注:rootは必ずしもallowed_usersに記載されているわけではありませんが、リストに記載されていれば多少安全だと感じています。

Step 3. On /etc/pam.d/sshd, add pam_listfile.so with sufficient flag

before pam_slurm.so (e.g. my /etc/pam.d/sshd looks like this):

ステップ3. /etc/pam.d/sshdで、pam_slurm.soの前に十分なフラグを付けてpam_listfile.soを追加します(たとえば、/ etc / pam.d / sshdは次のようになります)。

#%PAM-1.0 auth required pam_sepermit.so auth include password-auth account sufficient pam_listfile.so item=user sense=allow file=/etc/ssh/allowed_users onerr=fail account required pam_slurm.so account required pam_nologin.so account include password-auth password include password-auth # pam_selinux.so close should be the first session rule session required pam_selinux.so close session required pam_loginuid.so # pam_selinux.so open should only be followed by sessions to be executed in the user context session required pam_selinux.so open env_params session optional pam_keyinit.so force revoke session include password-auth

(Information courtesy of Koji Tanaka, Indiana University)

(情報提供:インディアナ大学田中浩二)

How can I dry up the workload for a

maintenance period?

メンテナンス期間のワークロードをどのように枯渇させることができますか?

Create a resource reservation as described b.

説明に従ってリソース予約を作成しますb。

Slurm's

Resource Reservation Guide.

Slurmのリソース予約ガイド。

How can PAM be used to control a user's limits on

or access to compute nodes?

PAMを使用して、計算ノードに対するユーザーの制限またはアクセスを制御するにはどうすればよいですか?

To control a user's limits on a compute node:

計算ノードでのユーザーの制限を制御するには:

First, enable Slurm's use of PAM by setting UsePAM=1 in

slurm.conf.

まず、slurm.confでUsePAM = 1を設定して、SlurmによるPAMの使用を有効にします。

Second, establish PAM configuration file(s) for Slurm in /etc/pam.conf

or the appropriate files in the /etc/pam.d directory (e.g.

/etc/pam.d/sshd by adding the line "account required pam_slurm.so".

次に、/ etc / pam.conf内のSlurmのPAM構成ファイル、または/etc/pam.dディレクトリ内の適切なファイル(/etc/pam.d/sshdなど)に、「account required pam_slurm。そう"。

A basic configuration you might use is:

使用できる基本的な構成は次のとおりです。

account required pam_unix.so account required pam_slurm.so auth required pam_localuser.so session required pam_limits.so

Third, set the desired limits in /etc/security/limits.conf.

3番目に、/ etc / security / limits.confで必要な制限を設定します。

For example, to set the locked memory limit to unlimited for all users:

たとえば、すべてのユーザーに対してロックされたメモリ制限を無制限に設定するには、次のようにします。

* hard memlock unlimited * soft memlock unlimited

Finally, you need to disable Slurm's forwarding of the limits from the

session from which the srun initiating the job ran.

最後に、ジョブを開始したsrunが実行されたセッションからのSlurmによる制限の転送を無効にする必要があります。

By default

all resource limits are propagated from that session.

デフォルトでは、すべてのリソース制限がそのセッションから伝達されます。

For example, adding

the following line to slurm.conf will prevent the locked memory

limit from being propagated:PropagateResourceLimitsExcept=MEMLOCK.

たとえば、slurm.confに次の行を追加すると、ロックされたメモリ制限が伝達されなくなります。PropagateResourceLimitsExcept= MEMLOCK。

To control a user's access to a compute node:

計算ノードへのユーザーのアクセスを制御するには:

The pam_slurm_adopt and pam_slurm modules prevent users from

logging into nodes that they have not been allocated (except for user

root, which can always login).

pam_slurm_adoptモジュールとpam_slurmモジュールは、割り当てられていないノードにユーザーがログインできないようにします(常にログインできるユーザーrootを除く)。

They are both included with the Slurm distribution.

どちらもSlurmディストリビューションに含まれています。

The pam_slurm_adopt module is highly recommended for most installations,

and is documented in its own guide.

pam_slurm_adoptモジュールは、ほとんどのインストールで強く推奨されており、独自のガイドに記載されています。

pam_slurm is older and less functional.

pam_slurmは古く、機能的ではありません。

These modules are built by default for RPM packages, but can be disabled using

the .rpmmacros option "%_without_pam 1" or by entering the command line

option "--without pam" when the configure program is executed.

これらのモジュールはRPMパッケージのデフォルトでビルドされますが、.rpmmacrosオプション "%_without_pam 1"を使用するか、configureプログラムの実行時にコマンドラインオプション "--without pam"を入力することで無効にできます。

Their source code is in the "contribs/pam" and "contribs/pam_slurm_adopt"

directories respectively.

それらのソースコードはそれぞれ「contribs / pam」および「contribs / pam_slurm_adopt」ディレクトリにあります。

The use of either pam_slurm_adopt or pam_slurm does not require

UsePAM being set. The two uses of PAM are independent.

pam_slurm_adoptまたはpam_slurmを使用する場合、UsePAMを設定する必要はありません。PAMの2つの使用法は独立しています。

Why are jobs allocated nodes and then unable

to initiate programs on some nodes?

ジョブがノードに割り当てられ、一部のノードでプログラムを開始できないのはなぜですか?

This typically indicates that the time on some nodes is not consistent

with the node on which the slurmctld daemon executes.

これは通常、一部のノードの時間が、slurmctldデーモンが実行されるノードと一致していないことを示しています。

In order to

initiate a job step (or batch job), the slurmctld daemon generates

a credential containing a time stamp.

ジョブステップ(またはバッチジョブ)を開始するために、slurmctldデーモンはタイムスタンプを含む資格情報を生成します。

If the slurmd daemon

receives a credential containing a time stamp later than the current

time or more than a few minutes in the past, it will be rejected.

slurmdデーモンが、現在時刻よりも後のタイムスタンプまたは過去数分よりも長いタイムスタンプを含む資格情報を受け取った場合、それは拒否されます。

If you check in the SlurmdLogFile on the nodes of interest, you

will likely see messages of this sort: "Invalid job credential from

<some IP address>: Job credential expired."

対象のノードでSlurmdLogFileをチェックインすると、次のようなメッセージが表示される可能性があります。 :ジョブ資格情報の有効期限が切れています。」

Make the times

consistent across all of the nodes and all should be well.

すべてのノードで時間を一致させ、すべてが適切である必要があります。

Why does slurmctld log that some nodes